728x90

Norm?

- 벡터의 크기/길이를 측정하는 함수(두 벡터 사이의 거리를 측정하는 방법)

- 원점부터 벡터 좌표까지의 거리 혹은 magnitude

- 각 요소별로 요소 절대값을 p번 곱한 값의 합을 p 제곱근한 값

위 식에서 p는 Norm 의 차수를 의미함

p=1 이면 L1 Norm , p=2 이면 L2 Norm

n은 해당 벡터의 원소 수

L1 Norm?

- 벡터의 요소에 대한 절대값의 합

- Manhattan norm 이라고도 부름

L2 Norm?

- 원소의 제곱의 합에 루트, 원점으로 부터 직선 거리

- Euclidean norm 이라고도 부름

L1 Norm vs. L2 Norm 차이점?

- L1은 여러가지 path를 가지지만 L2 Norm은 Unique shortest path를 가짐

- L1 Norm: 빨간색, 파란색, 노란색

L2 Norm: 초록색

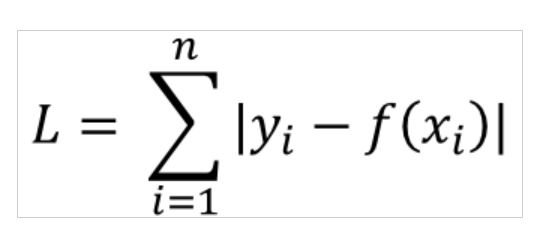

L1 Loss?

- 실제값과 예측치 차이의 절대값을 구한, 오차들의 합

- Least absolute deviations(LAD), Least absolute Errors(LAE), Least absolute value(LAV), Least absolute residual(LAR), Sum of absolute deviations 라고 부름

L2 Loss?

- 실제값과 예측치 차이의 제곱의 합

- Least squares error(LSE) 라고 부름

L1 Loss vs. L2 Loss 차이점?

- L2가 오차의 제곱을 더하기 때문에 outlier에 더 큰 영향을 받음

- L1 loss 가 outlier에 덜 민감함

- outlier 가 적당히 무시되길 바라면 L1을 사용하고, outlier에 신경써야한다면 L2 loss 사용

Reference

728x90

'SW > 인공지능' 카테고리의 다른 글

| [인공지능] 딥러닝이란? 심층학습/딥러닝 기본 개념에 대해 알아보자! (0) | 2020.12.12 |

|---|---|

| [데이터분석] 빅데이터란? (0) | 2020.07.09 |

댓글